Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- 해킹백

- 윤리적해커

- webofscience

- 보복해킹

- Selenium

- CVE

- 해킹

- cna

- blindSQL

- Los

- clarivate

- 인공지능윤리

- 디지털자구행위

- 웹취약점

- CTF

- 가장인간적인미래

- 윤송이

- LordOfSQLInjection

- 과학기술전문사관

- ACDC

- 사이버위협

- hackingback

- 밀리테크챌린지

Archives

- Today

- Total

프리미의 공간

[TIL] LLM 출력의 confidence를 정의하는 방법 본문

LLM의 출력을 얼마나 신뢰할 수 있는지, confidence를 측정하는 여러 방법이 발표되었지만, 오늘은 P(True) Calibration 방법론에 대해 소개한다.

Input: [게시글 본문] Classifier: 위 글은 '정치' 카테고리로 분류되었습니다.

Question: 당신의 분류가 정확합니까? (Yes/No로만 답하세요)

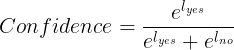

'Yes' 토큰의 로짓과 'No' 토큰의 로짓을 각각 추출한 뒤, Softmax를 적용해 정규화된 confidence score를 계산한다.

특히 모델에게 답변의 이유(Chain-of-Thought)를 먼저 말하게 한 뒤 이 질문을 던질 때 정확도가 상승한다고 한다.

Reference

- Language Models (Mostly) Know What They Know, Kadavath et al., 2022.

- Just Ask for Calibration: Strategies for Eliciting Calibrated Confidence Scores from LLMs, Tian et al., 2023.

- Can LLMs Express Their Uncertainty? An Empirical Evaluation, Xiong et al., 2023.